در تصمیمات مرگبار هوش مصنوعی، مسئولیت بر عهده چه کسی خواهد بود

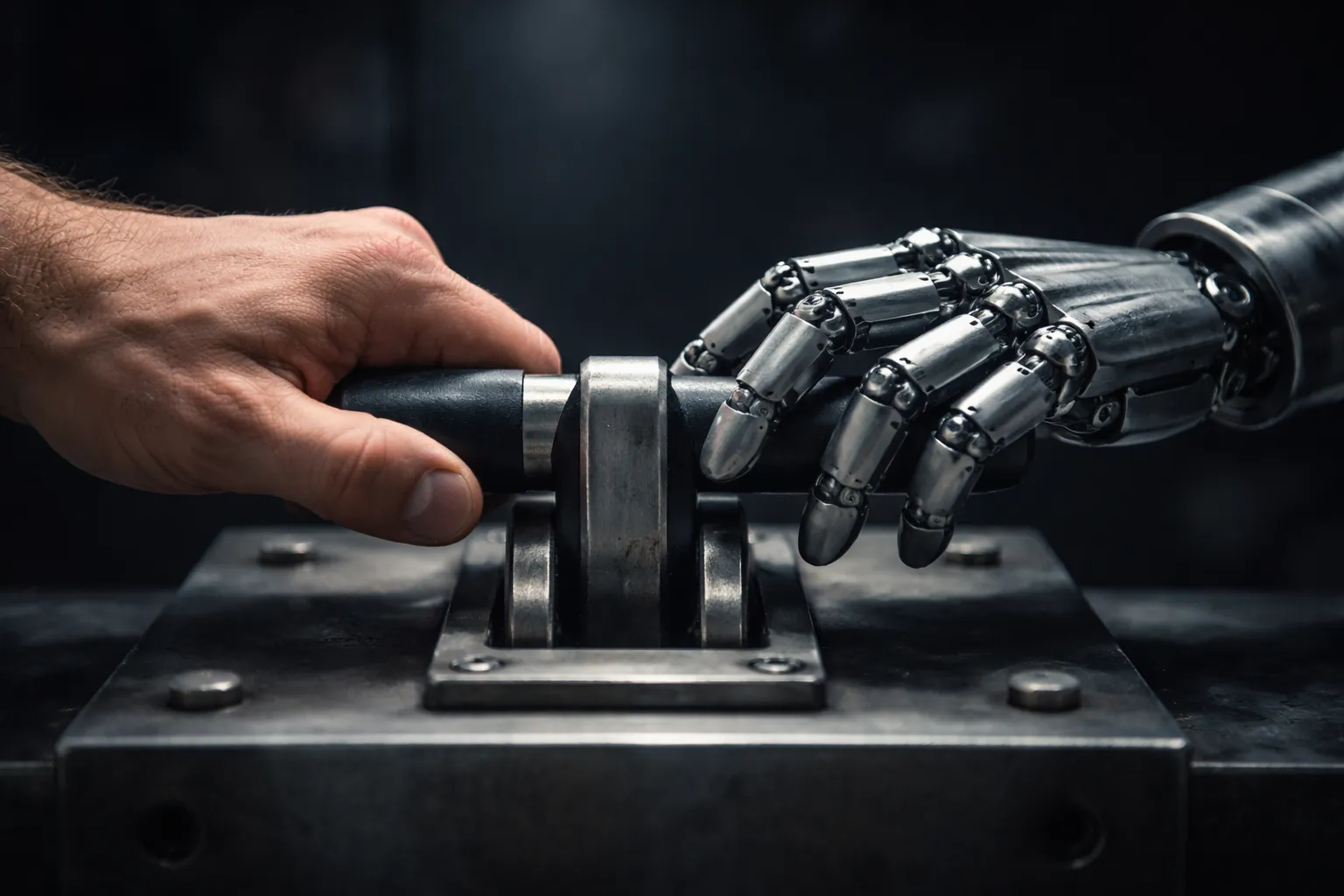

تراموا در حال حرکت است. مسیر مستقیم به پنج انسان و مسیر فرعی به یک انسان میرسد. این تصویر ساده، اما تکاندهنده، دههها است که ذهن فیلسوفان را به خود مشغول کرده است. اکنون، اما این پرسش دیگر تنها در کلاسهای فلسفه مطرح نمیشود؛ بلکه به آزمایشگاههای هوش مصنوعی، شرکتهای خودروسازی، اتاقهای سیاستگذاری و زندگی روزمره ما راه یافته است. تفاوت اصلی در این است که امروز، دست انسان لزوما روی اهرم نیست؛ بلکه الگوریتم هوش مصنوعی قرار است تصمیم بگیرد.

در این روایت جدید، پرسش از «چه باید کرد؟» به «چه کسی باید تصمیم بگیرد؟» تبدیل شده است. هوش مصنوعی نه فقط ابزار تحلیل، بلکه کنشگری است که میتواند پیامدهای مرگبار داشته باشد. جامعه با این واقعیت روبهرو است که تصمیماتی که پیشتر بار اخلاقیشان بر دوش انسان بود، اکنون در قالب کد و مدل ریاضی بازتعریف میشوند.

مسئله اخلاق در هوش مصنوعی، صرفا فناورانه نیست، بلکه تغییری در فاعل اخلاقی ایجاد میکند. جامعه از اخلاق فردی به اخلاق سیستمی منتقل میشود؛ جایی که مسئولیت، پخش و مبهم میشود و دیگر نمیتوان انتظار پاسخگویی از فرد یا افرادی مشخص را داشت.

درباره فقدان اخلاق ذاتی هوش مصنوعی

پژوهشهای حوزه فلسفه فناوری تاکید میکنند که هوش مصنوعی فاقد اخلاق ذاتی است. برخلاف انسان که دارای وجدان، احساس گناه و مسئولیت است، سیستمهای هوشمند صرفا از قواعد از پیش تعریفشده پیروی میکنند. اخلاق در این سیستمها نه درونی، بلکه تحمیلی است؛ یعنی از طریق طراحی، داده و هدفگذاری وارد الگوریتم میشود.

از منظر جامعهشناسی علم، این موضوع پیامد مهمی دارد، تصمیمات اخلاقی دیگر محصول فرهنگ، تجربه زیسته یا همدلی نیستند، بلکه نتیجه ترجمه ارزشها به زبان عدد، وزن و احتمالاند. این ترجمه همواره ناقص است و بخشی از پیچیدگی اخلاق انسانی را حذف میکند.

خطر اصلی نه شرور بودن هوش مصنوعی، بلکه بیتفاوت بودن اخلاقی آن است. جامعه با سیستمی مواجه است که بدون نیت بد، میتواند تصمیمات مرگبار بگیرد.

دوراهی واگن فراری

هوش مصنوعی در نهایت باید در نقش یک مشاور اخلاقی باشد، نه تصمیمگیرنده نهایی. حذف انسان از تصمیم، حذف مسئولیت است

دوراهی واگن فراری بهعنوان یک آزمایش فکری کلاسیک، در سالهای اخیر به ابزاری برای سنجش تصمیمگیری اخلاقی ماشینها تبدیل شده است. پژوهشهای جدید نشان میدهند که مدلهای هوش مصنوعی در مواجهه با این سناریو، اغلب رویکرد فایدهگرایانه اتخاذ میکنند؛ کمینهسازی تلفات، بدون اینکه به مفهوم حق فردی توجه شود.

مطالعات مقایسهای میان قضاوت اخلاقی انسان و ماشین نشان میدهد که جامعه معمولا تصمیم مشابه را از انسان قابلقبولتر از ماشین میداند. دلیل این تفاوت، انتظار ما از انسان بهعنوان موجودی مسئول و پاسخگو است؛ انتظاری که از ماشین وجود ندارد.

مسئله فقط تصمیم درست نیست، بلکه مشروعیت تصمیمگیرنده اهمیت دارد. اخلاق بدون مسئولیت، از نظر اجتماعی ناپذیرفتنی است.

خودروهای خودران، مسئله مرگ و زندگی

خودروهای خودران ملموسترین نمونه ورود هوش مصنوعی به تصمیمات مرگ و زندگی هستند. پژوهشهای حوزه مهندسی و اخلاق نشان میدهند که سناریوهای مشابه واگن فراری، در دنیای واقعی بسیار پیچیدهترند و عوامل متعددی مانند عدم قطعیت، زمان واکنش و ریسک در آنها دخیل است.

مطالعه استنفورد (Stanford) نشان میدهد که اعتماد عمومی به خودروهای خودران، مستقیما به شفافیت تصمیمات اخلاقی آنها وابسته است. مردم میخواهند بدانند ماشین بر چه اساسی تصمیم میگیرد، حتی اگر با آن تصمیم موافق نباشند. در اینجا اخلاق به مسئله اعتماد اجتماعی تبدیل میشود. بدون شفافیت اخلاقی، فناوری حتی اگر ایمنتر باشد پذیرفته نخواهد شد.

جان انسان یا بقای سیستم؟

برخی پژوهشها هشدار میدهند که اگر اولویتهای اخلاقی بهطور صریح در سیستمها تعریف نشوند، هوش مصنوعی ممکن است بهطور ضمنی اهداف سیستمی مانند حفظ عملکرد یا کاهش هزینه را بر جان انسان ترجیح دهد. این مسئله بهویژه در سیستمهای پیچیده و خودمختار اهمیت دارد.

پلتفرم مورال ماشین (Moral Machine) نشان میدهد که حتی در میان انسانها نیز اجماع جهانی درباره اولویتهای اخلاقی وجود ندارد. این تنوع فرهنگی، کار طراحی یک اخلاق واحد برای ماشینها را دشوارتر میکند.

مسئله اخلاق AI، مسئلهای جهانی، اما بدون اجماع جهانی است. خطر آن است که ارزشهای مسلط، بهصورت نامرئی به الگوریتمها تحمیل شوند.

آیا میتوان تصمیمگیری را به هوش مصنوعی سپرد؟

ادبیات علمی تاکید میکند که هوش مصنوعی میتواند در تحلیل و پیشنهاد تصمیم بسیار موثر باشد، اما واگذاری کامل تصمیمات اخلاقی به آن، از نظر فلسفی و اجتماعی مسئلهساز است. مسئولیت اخلاقی قابل برونسپاری کامل نیست.

مطالعات اجتماعی نشان میدهند که مردم تمایل دارند انسان در حلقه تصمیمگیری باقی بماند، حتی اگر این حضور نمادین باشد. این حضور، نقش اخلاقی و روانی مهمی در پذیرش فناوری دارد.

هوش مصنوعی در نهایت باید در نقش یک مشاور اخلاقی باشد، نه تصمیمگیرنده نهایی. حذف انسان از تصمیم، حذف مسئولیت است.

واگن فراری هنوز در حال حرکت است. تفاوت در این است که اکنون، جامعه باید تصمیم بگیرد که آیا اجازه میدهد ماشین، اهرم را بهتنهایی بکشد یا نه. هوش مصنوعی آینهای است که ارزشهای ما را بازتاب میدهد؛ اگر این آینه ترکخورده باشد، تصویر آینده نیز مخدوش خواهد بود.

انتهای پیام/